In den Blogeinträgen „Think big – durchgängiges Prozessmanagement bei Versicherungen“ und „Prozessmanagement: Input, Anliegenerkennung und Datenextraktion“ wird auf die Bedeutung der Prozesssteuerung in der Versicherungswirtschaft eingegangen. An dieser Stelle möchten wir diese Themen aufgreifen und ein architekturelles Lösungsmuster beschreiben: Event-Streaming.

Eine Begriffserklärung

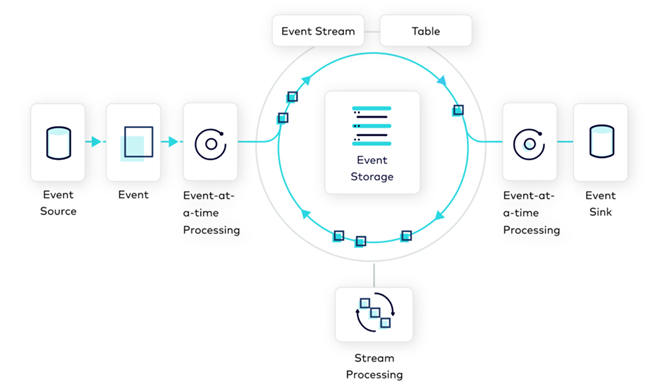

Event-Streaming ist ein Programmierparadigma, welches Datenströme in das Zentrum der Verarbeitung stellt. Genauer gesagt die Abfolge von Ereignissen (Events) im Verlauf der Zeit. Ein Ereignis ist dabei die Veränderung des Status eines beliebigen Objektes. In einer Event-Streaming-Architektur werden Informationen aus diversen, verteilten Systemen fortlaufend in Echtzeit gesammelt und basierend auf der definierten Stream Topology durch einen oder mehrere Broker verarbeitet. Das Ergebnis dieser Verarbeitung ist ein neues Event, welches dann erneut im Event-Streaming verarbeitet wird. Dank einer solchen Architektur eröffnen sich zahlreiche Vorteile, welche durch herkömmliche Datenverarbeitung (Speicherung von Daten in relationalen Datenbanken und getriggerte Ausführung von Abfragen) nicht möglich sind. Dies sind unter anderem:

- Echtzeit-Verarbeitung/Visualisierung

- Lose Kopplung über Daten fördert Austauschbarkeit und Möglichkeit von kleinen Deployment-Units

- Nahezu unbegrenzte Skalierungsmöglichkeiten

- Transparenz und Revisionssicherheit aller Vorgänge im System

Event-Streaming als Basis für eine Prozesssteuerungs-Engine in der Versicherungsbranche

Event-Streaming als Basis für eine Prozesssteuerungs-Engine in der Versicherungsbranche

Ein BPMN-Prozess ist im Grunde nichts anderes als ein Event-Stream. Ein Geschäftsprozess befindet sich in einem Zustand A. Die Verarbeitung eines Events – z. B. eine Nutzeraktion oder Ergebnis eines externen Serviceaufrufs – resultiert in Zustand B. Die Verarbeitung eines BPMN-Elements wird dabei von einem allgemeinen oder spezifischen Broker übernommen.

Die Event-Streaming-Architektur bildet das Rückgrat der Produkte in|sure Workflow und Workplace. Wir setzen dazu Apache Kafka ein, welches im Zusammenspiel mit Kafka Streams einen De-facto-Standard im Bereich des Event-Streamings darstellt. So setzen z. B. laut eigener Aussage 80 % der Fortune-100-Unternehmen und 10 von 10 der grössten Versicherungsunternehmen Kafka ein.

Task-Routing

Das Routing von Aufgaben an Sachbearbeiter ist ein ideales Einsatzszenario für Event-Streaming, da sich hierbei der Zustand der Aufgaben und Sachbearbeiter ständig ändert und eine Echtzeitverarbeitung notwendig ist.

Skalierung

Versicherungen haben eine recht gleichbleibende Grundlast an Prozessinstanzen, darüber hinaus kommt es aber zu geplanten (z. B. Monats-/Jahresverarbeitungen) und ungeplanten (z. B. Grossschadenereignissen) Lastspitzen. Hier ist besonders die Skalierungsmöglichkeit, welche während des Betriebs erfolgen kann, von grossem Nutzen. Dies gilt insbesondere für den Fall des Betriebs in der Cloud.

Echtzeit – KPIs

Die Event-Streaming-Architektur ermöglicht die Auswertung und Darstellung von KPIs in Echtzeit, indem die Reporting-Komponente als zusätzlicher Konsument der Daten hinzugefügt wird.

Kundenerweiterbarkeit

Alle in|sure Produkte bieten einen Release-fähigen Kern. Event-Streaming sorgt für die Entkopplung der Verarbeitungslogiken, wodurch es möglich wird, jeden einzelnen Broker durch kundenindividuelle Implementierungen auszutauschen.

Nutzung der Daten durch Drittsysteme

Die Event-Streaming-Plattform von Apache Kafka ermöglicht die einfache Integration von zusätzlichen Datenquellen ebenso leicht wie die Nutzung der vorhandenen Daten durch weitere Konsumenten. Dadurch können zusätzliche Mehrwerte geschaffen werden.

Bei adesso insurance solutions sind wir davon überzeugt, dass die Event-Streaming-Architektur die richtige Wahl zur Lösung der fachlichen Herausforderungen im Umfeld der Prozesssteuerung ist und obendrein das Zentrum einer datengetriebenen Verarbeitung in den Kernsystemen eines Versicherers bilden kann.